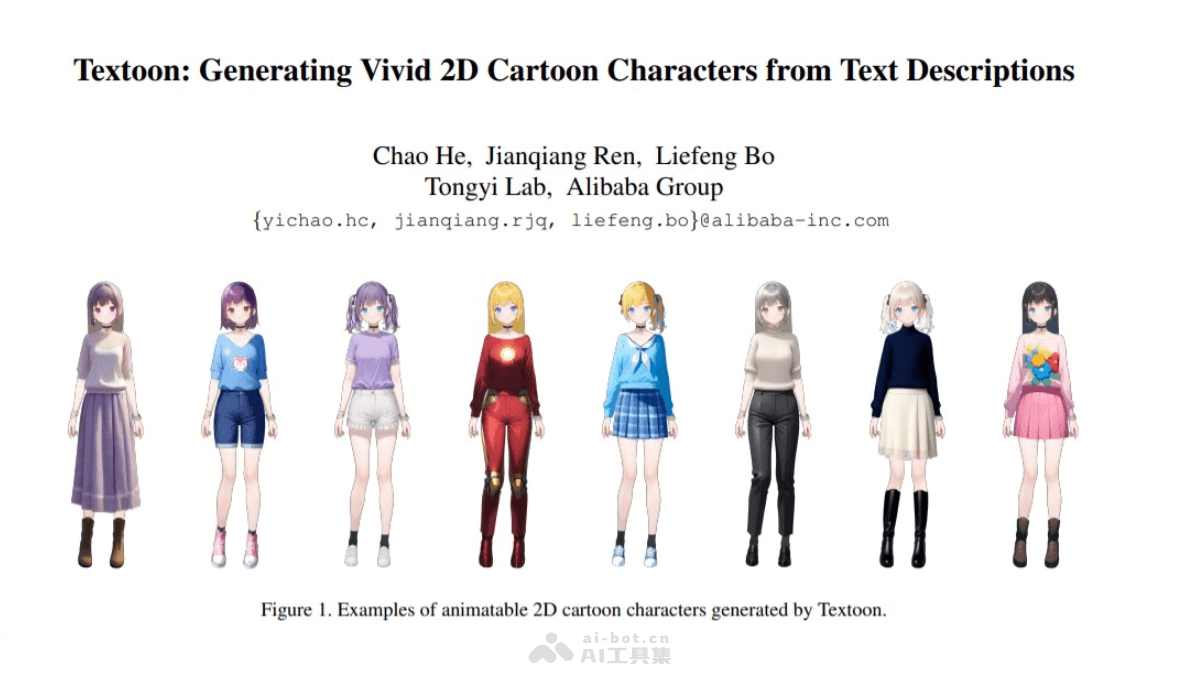

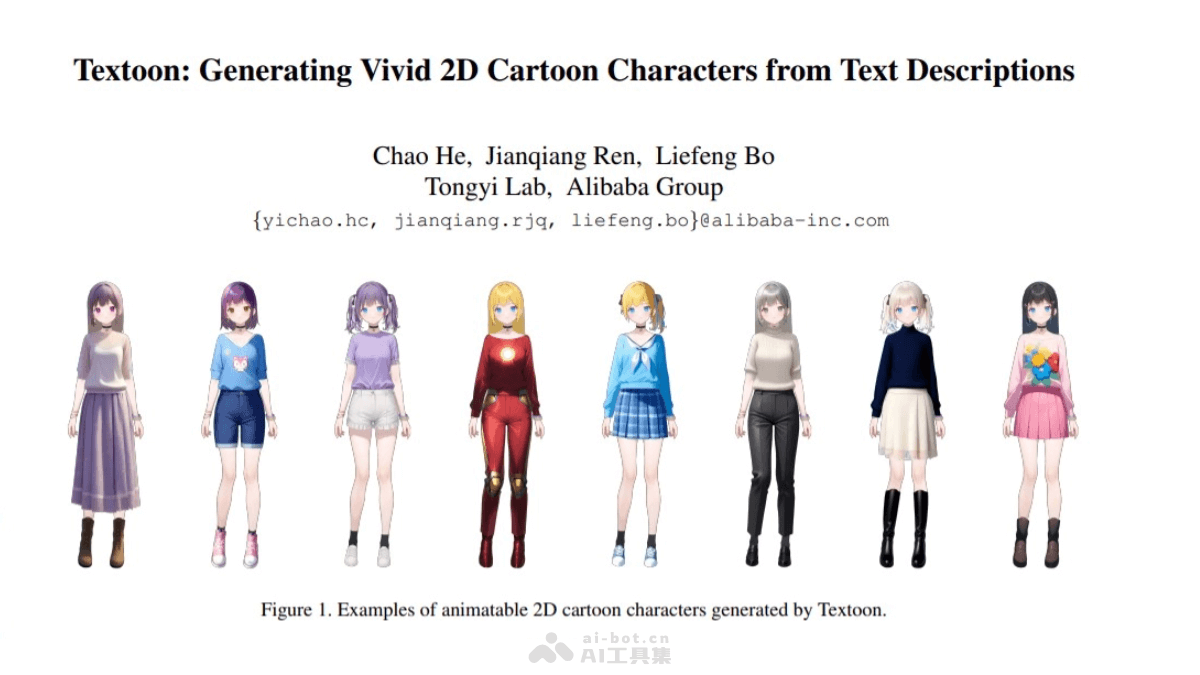

Textoon是什么

Textoon是阿里巴巴集团通义实验室推出的创新项目,首个能根据文本提示生成Live2D格式2D卡通角色的方法。基于先进的语言和视觉模型,能在一分钟内生成多样化且可交互的2D角色。生成的角色支持动画效果,适用于HTML5渲染,可广泛应用于影视、游戏、社交媒体和广告等领域。

Textoon的主要功能

文本解析:Textoon 使用微调的大语言模型(LLM),能够从复杂文本中提取详细信息,如发型、眼色、服装类型等。可控外观生成:通过文本到图像模型(如SDXL),Textoon 可以根据用户输入生成角色的外观,并确保生成结果符合用户描述。编辑与修复:用户可以对生成的角色进行编辑,调整细节或修复不理想的部分。动画增强:Textoon 集成了ARKit的面部表情参数,显著提升了角色的动画表现力。多语言支持:Textoon 支持中英文提示词,能满足不同用户的语言需求。

Textoon的技术原理

文本解析与意图理解:Textoon 基于微调的大语言模型(LLM),能从复杂的文本描述中提取详细信息,例如发型、发色、眼睛颜色、服装类型等。准确的文本解析能力使系统能理解用户输入的描述,转化为具体的视觉特征。Live2D 技术集成:生成的角色以Live2D格式输出,这种格式支持高效的渲染性能和灵活的动画表现。Live2D技术通过多层次的2D绘制和骨骼绑定,赋予角色丰富的表情和动作能力。Textoon 还集成了ARKit的能力,进一步提升了角色的动画表现力。高效渲染与兼容性:生成的Live2D模型具有高效的渲染性能,适用于HTML5渲染,适合在移动设备和网页应用中使用。

Textoon的项目地址

项目官网:https://human3daigc.github.io/Textoon_webpage/arXiv技术论文:https://arxiv.org/pdf/2501.10020

Textoon的应用场景

创意设计:Textoon 可以帮助设计师快速生成角色原型,节省设计时间和成本。通过简单的文本描述,用户可以在短时间内生成具有丰富细节的 2D 卡通角色,对其进行编辑和调整。游戏开发:在游戏开发中,开发者可以用 Textoon 快速生成角色原型,用于游戏概念设计或直接应用于游戏中的角色动画。动漫制作:Textoon 能根据详细的文本描述生成高质量的 2D 卡通角色,适用于动漫制作中的角色设计和动画制作。生成的角色可以直接用于动画视频的制作,或者作为动画师的参考。文学创作:对于文学创作者来说,Textoon 可以将文字描述中的角色形象具象化,帮助作者更好地构思角色外观和性格特点,增强创作的可视化效果。教育与培训:Textoon 可以用于制作教学视频或互动学习材料。通过生成生动的 2D 卡通角色,可以为学生提供更直观、有趣的学习体验,例如制作虚拟教师或动画讲解。